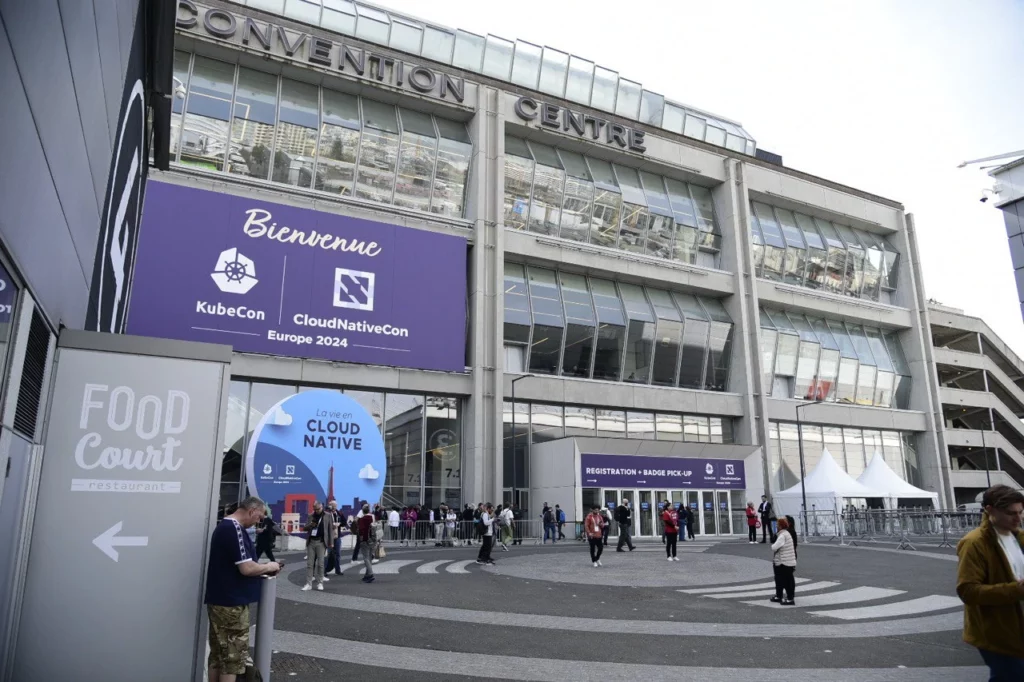

KubeCon Europe 2024: resumen del segundo día

Compartimos nuestras impresiones sobre el segundo día de la recién finalizada KubeCon Europe 2024, ahora ya de vuelta en casa. Aunque el cansancio y la emoción nos han dejado poco espacio para plasmar todo lo vivido, aquí estamos, contando, finalmente, lo que experimentamos día a día.

La organización de la KubeCon sigue siendo impecable, como desde el principio del evento. Desde primera hora, miles de personas nos esforzamos por conseguir un buen lugar en las KeyNotes que, aun celebrándose en un espacio colosal, suelen llenarse rápidamente debido al gran interés que generan. Esta vez, el enfoque principal ha sido la inteligencia artificial. Explorando diversas áreas como el funcionamiento de cargas de trabajo en Kubernetes y las últimas novedades en hardware, destacando especialmente la presentación de NVIDIA, apoyada por Intel como Diamond Sponsor.

Las charlas han sido variadas y enriquecedoras, abordando temas como CoreDNS, OpenTelemetry, OCI, OAuth2, Crossplane o GitOps, entre otros. El programa completo se puede revisar en el canal de Youtube oficial de KubeCon. Durante este día se discutieron algunos de los que, en mi opinión personal, son los temas clave de la industria: seguridad transversal, observabilidad y optimización de recursos y costes.

Los stands de exhibición ofrecían una amplia gama de productos y soluciones. Además de la valiosa interacción con los desarrolladores y creadores, pudimos obtener información directamente de la fuente, cosa que pocas veces ocurre. Algunos incluso tuvieron la oportunidad de obtener un autógrafo de figuras destacadas, como ha hecho nuestro compañero Alberto con Viktor Farcic.

Con el gurú @vfarcic tratando de adivinar el futuro de Kubernetes at #KubeCon2024 #KubeConEU 🔮.

— PREFAPP (@prefapp) March 20, 2024

Nice to meet you! pic.twitter.com/WJDu0eM7xG

El día fue largo, de 7 de la mañana a 7 de la tarde, pero gratificante. Cubrir todo el evento era un desafío, así que priorizamos nuestras actividades y nos dividimos el trabajo. Nos enfocamos en resolver dudas, descubrir nuevas soluciones y aprender cómo otros abordan problemas comunes. Algunos de estos serían la gestión de cientos de nodos sobre miles de clústeres, y cómo se maneja la gran escala, el multitenancy y la comunicación segura entre ellos.

Aunque no pudimos abarcar todo, nos sentimos satisfechos con nuestra participación. Nos hemos dado cuenta de que estamos en sintonía con las necesidades del cliente y la industria, pero siempre buscamos mejorar. Esta conferencia nos ha inspirado a adoptar un enfoque más orgánico y funcional en nuestro trabajo diario, así como a organizar mejor nuestra visión y misión. Para nuestros clientes, esperamos ofrecer productos y servicios más definidos y estructurados que satisfagan sus necesidades y les brinden mejor cobertura y más seguridad.

En resumen, ha sido un día intenso y enriquecedor. Reconocemos que aún tenemos mucho por mejorar, pero estamos en el camino correcto hacia la excelencia. ¡Mañana más, con lo acontecido el día 21!